- Noua tehnică a OpenAI, numită „jocurile Prover-Verifier”, îmbunătățește lizibilitatea rezultatelor A.I. fără a slăbi performanța.

- Metoda folosește două modele A.I. care se antrenează reciproc: un „prover” care generează soluții și un „verifier” care le evaluează.

- Rezultatele arată un echilibru mai bun între acuratețe și claritate, iar astfel e mai ușor de înțeles și verificat de oameni.

OpenAI anunță o nouă metodă de antrenare a modelelor lingvistice avansate care îmbunătățește semnificativ lizibilitatea și verificabilitatea rezultatelor generate. Tehnica, numită „Jocurile Prover-Verifier”, e un pas important în direcția creării unor sisteme A.I. mai de încredere și mai ușor de înțeles pentru utilizatorii umani.

Cum au fost create jocul Jocurile Prover-Verifier

Pe măsură ce modelele lingvistice devin tot mai puternice și sunt utilizate în aplicații din ce în ce mai complexe, cum ar fi rezolvarea problemelor matematice, devine important ca rezultatele generate să fie nu doar corecte, ci și ușor de înțeles și verificat de către oameni. Cercetătorii de la OpenAI au observat că atunci când optimizează procesul de rezolvare a problemelor doar pentru a obține răspunsul corect, soluțiile rezultate pot deveni mai greu de înțeles.

De fapt, atunci când evaluatorii umani cu timp limitat au fost rugați să evalueze aceste soluții foarte optimizate, au făcut aproape de două ori mai multe erori comparativ cu evaluarea unor soluții mai puțin optimizate. Această descoperire subliniază importanța nu doar a corectitudinii, ci și a clarității și ușurinței de verificare a textului generat de A.I.

Metoda „Jocurilor Prover-Verifier”

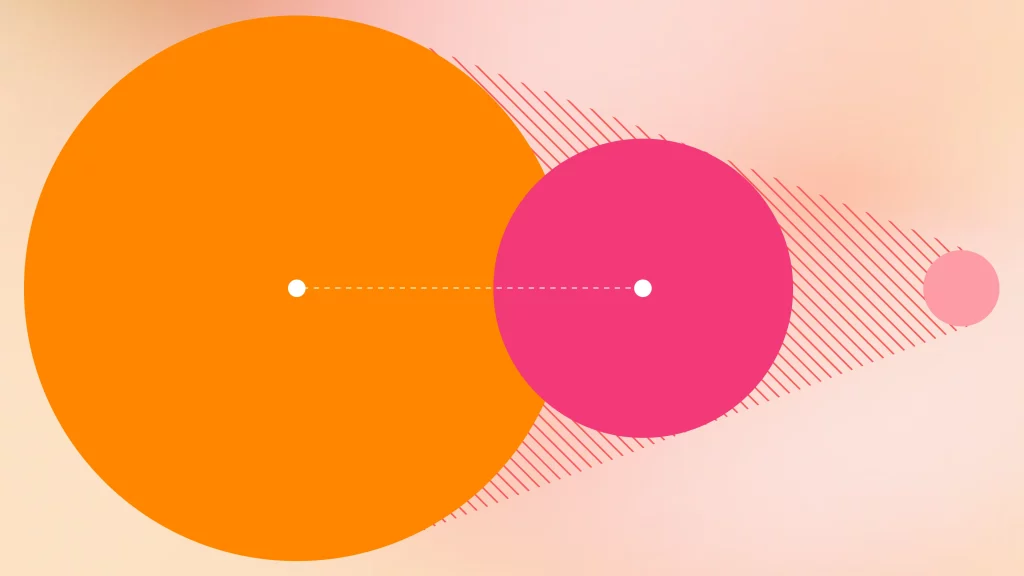

Pentru a aborda această problemă, OpenAI a dezvoltat o tehnică inspirată din teoria jocurilor, care implică doi „jucători”:

1.Un „prover” (demonstrator) – un model lingvistic puternic care generează soluții.

2.Un „verifier” (verificator) – un model mai slab care verifică acuratețea soluțiilor.

Procesul de antrenare alternează între două faze:

1.Antrenarea verificatorului: Modelul slab este antrenat să prezică corectitudinea soluțiilor generate de demonstrator.

2.Antrenarea demonstratorului: Modelul puternic este instruit să joace fie un rol de ajutor, fie unul de intrus:

În rolul de ajutor, este recompensat pentru soluții corecte care obțin scoruri mari de la verificator, iar în rolul intrus, este recompensat pentru soluții incorecte care păcălesc verificatorul.

Pe măsură ce antrenamentul progresează, demonstratorul „intrus” este forțat să exploreze strategii diferite în fiecare rundă, deoarece verificatorul devine din ce în ce mai bun în detectarea erorilor. Antrenamentul se încheie atunci când intrusul nu mai poate produce soluții incorecte care să convingă verificatorul.

Rezultate cheie

Cercetătorii au descoperit că această metodă de antrenare produce trei modele utile:

1.Verificator robust: Capabil să distingă eficient între soluții corecte și incorecte, chiar și atunci când soluția este concepută pentru a induce în eroare.

2.Demonstrator de ajutor: Generează soluții care rămân lizibile pentru oameni și reduc erorile evaluatorilor umani.

3.Demonstrator intrus: Produce soluții incorecte subtile care inițial confuzează evaluatorii umani și scot în evidență domeniile care necesită îmbunătățiri suplimentare ale modelului.

Studiul arată că această metodă de antrenare a reușit să atingă un echilibru între performanță și lizibilitate.

Implicații și aplicații potențiale

Această cercetare are implicații semnificative pentru dezvoltarea unor sisteme A.I. mai de încredere și mai ușor de utilizat:

1.Îmbunătățirea comunicării om-A.I.: Prin generarea de explicații mai clare și mai ușor de verificat, modelele lingvistice pot deveni instrumente mai eficiente în domenii precum educația sau asistența medicală.

2. Creșterea încrederii în A.I.: Capacitatea de a verifica mai ușor rezultatele generate de A.I. poate duce la o adoptare mai largă a acestor tehnologii în domenii critice.

3. Alinierea A.I. cu valorile umane: Această metodă reprezintă un pas important în direcția creării unor sisteme A.I. care nu sunt doar corecte, ci și transparente și verificabile, în concordanță cu așteptările umane.

4. Aplicații în domenii complexe: Tehnica ar putea fi utilă în domenii precum rezolvarea problemelor matematice, programare sau analiză științifică.

Cercetarea OpenAI în domeniul Jocurilor Prover-Verifier e un pas important în direcția creării unor sisteme A.I. mai inteligibile și mai de încredere. Pe măsură ce modelele lingvistice devin tot mai puternice și sunt utilizate în aplicații tot mai complexe, capacitatea de a produce rezultate nu doar corecte, ci și ușor de înțeles și verificat de către oameni, va deveni din ce în ce mai importantă.